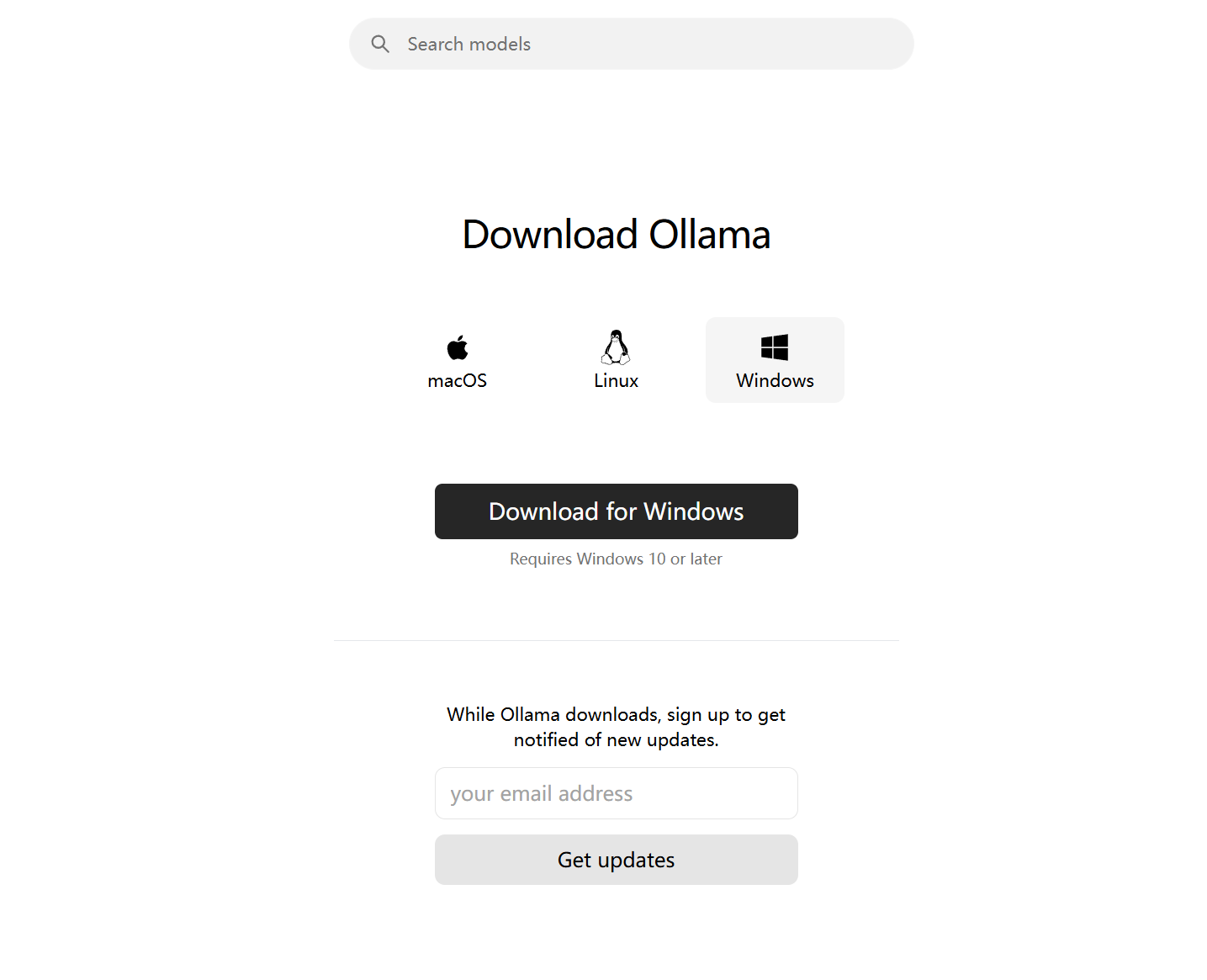

下载并安装Ollama

ollama下载地址:https://ollama.com/download

下载完毕后一路 Install安装即可。

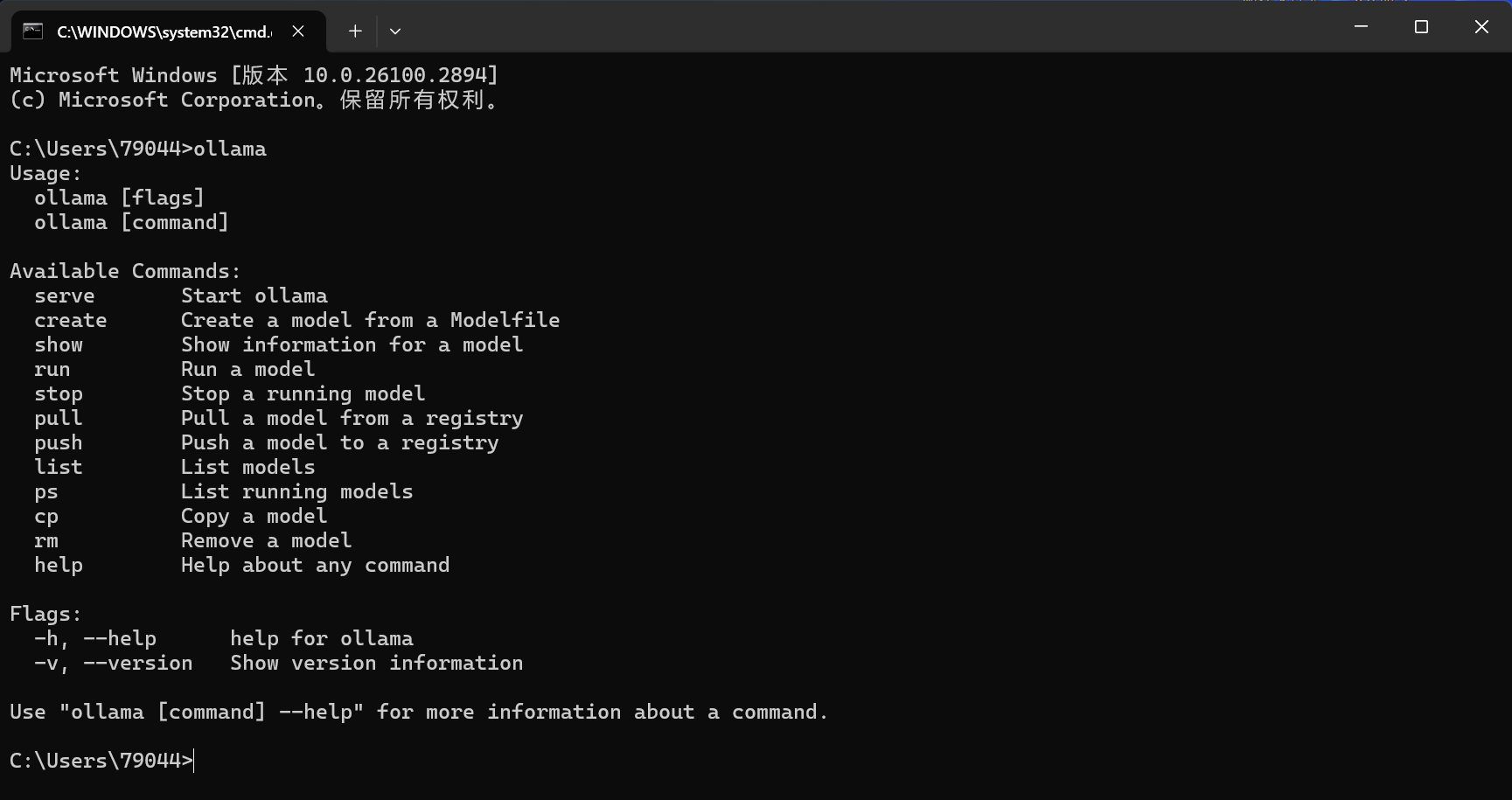

安装完成之后,打开一个cmd命令窗口,输入“ollama”命令,如果显示ollama相关的信息就证明安装已经成功了!

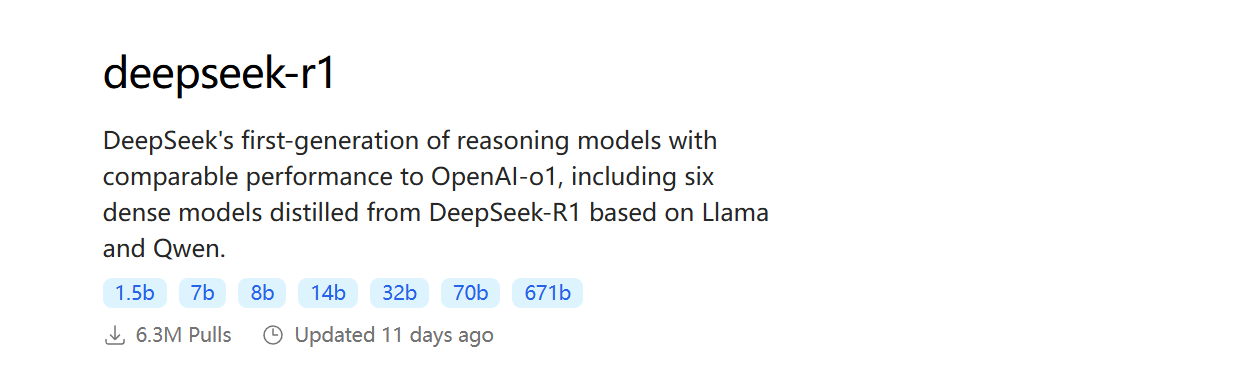

选择模型

deepseek r1模型下载页:https://ollama.com/library/deepseek-r1

模型参数大小从1.5b到671b不等,需要根据自己的电脑配置来选择

显存与模型参数的粗略关系

全精度(32位)模型:每1B参数约需 4GB显存(如:7B模型需28GB显存)。

半精度(16位)或量化(如4位):显存需求大幅降低:

4位量化:每1B参数约需 0.5GB显存(7B模型约需3.5GB显存)。

8位量化:每1B参数约需 1GB显存(7B模型约需7GB显存)。

由于ollama的deepseek r1模型已经提供了4位量化版本,我们可以先选择8B模型进行测试,理论上只需要4G的GPU显存,在cmd中执行以下命令即可自动下载并运行deepseek-r1的8b模型

ollama run deepseek-r1:8b模型加载成功后即可直接在命令行窗口中进行对话

评论区